Promienie pokazane na rysunku są dokładnie prześledzone, ale układ jest narysowany w większej skali w Y niż w X, aby wyraźniej pokazać separację promieni. Oczywiście promienie nie skupiają się ostro. ABERRACJA KULISTA SA na rysunku jest widoczna w ognisku osiowym. Promienie zewnętrzne skupiają się jako pierwsze i już się rozchodzą tam, gdzie skupiają się inne promienie. COMA jest również widoczna na rysunku w obrazie pozaosiowym. Promień przechodzący przez środek APERTURY wejściowej, zwany promieniem głównym, jest przesunięty w bok od ogniska promieni zewnętrznych. Obraz ma wygląd komety z głównym promieniem na czele. Jest również oczywiste, że oba ogniska nie znajdują się w tej samej płaszczyźnie, co jest ABERRACJĄ zwaną krzywizną Petzvala. Kolejną aberracją jest ASTIGMATYZM, w którym promienie zewnętrzne, prostopadłe do płaszczyzny rysunku, skupiają się dalej od obiektywu, ale nie są one widoczne. Poradnik na temat aberracji można znaleźć w katalogu Mellesa Griota: http://www.mellesgriot.com. Dla danej Ogniskowej aberracja sferyczna jest proporcjonalna do sześcianu średnicy apertury. Koma jest proporcjonalna do kwadratu apertury i wprost proporcjonalna do kąta pola. Astygmatyzm jest proporcjonalny do kwadratu kąta pola i jest wprost proporcjonalny do przysłony. Barwa osiowa jest wprost proporcjonalna do apertury, natomiast barwa boczna jest niezależna od apertury i jest wprost proporcjonalna do kąta pola. W przypadku soczewki singletowej aberracja sferyczna jest mniejsza, jeśli szkło ma wysoki współczynnik załamania światła, N, ponieważ dla danej ogniskowej potrzebna jest mniejsza krzywizna. Jednakże okulary o wyższym indeksie mają zwykle wyższą dyspersję, która zwiększa ABERRACJĘ CHROMATYCZNĄ. Jednowarstwowa powłoka przeciwodblaskowa na soczewce wykonanej ze szkła o wysokim współczynniku odbicia ma mniejszy współczynnik odbicia szczątkowego przy jednej długości fali, ale większe średnie straty niż w przypadku szkła o niskim współczynniku w szerokim paśmie długości fal. Zatem soczewka singletowa o wysokim współczynniku jest optymalna dla efektów monochromatycznych, ale szkło o niskim współczynniku i niskiej dyspersji jest lepsze dla szerokiego zakresu widma. Kolejnym czynnikiem branym pod uwagę przy wyborze szkła jest ciemnienie radiacyjne i fluorescencja

W porównaniu z teleskopem z dwoma zwierciadłami, który ma odległą źrenicę wyjściową nad zwierciadłem wtórnym, NGST ma swoją końcową źrenicę znacznie bliżej ogniska i dlatego jest mniej telecentryczny niż większość teleskopów. Celem odkształcalnego zwierciadła DM na NGST jest kompensacja resztkowych niedoskonałości kształtu aktywnego zwierciadła głównego. Jeśli teleskop kosmiczny ma ograniczoną dyfrakcję, wówczas kamery w instrumentach mogą być mniejsze i mieć dłuższe ogniskowe niż odpowiedniki w dużym teleskopie naziemnym, którego rozdzielczość jest ograniczona przez turbulencje atmosferyczne, zwane WIDZENIEM. Spektrograf przeznaczony dla małego teleskopu naziemnego będzie dobrze współpracował z dużym teleskopem kosmicznym.

Składa się z dziewięciu elementów: dubletu sprzężonego z cieczą, singletu, trójki sprzężonej z cieczą, dubletu i wreszcie soczewki spłaszczającej pole singletowe w pobliżu ogniska. Pokazano także filtr i okno Dewara. Największy element ma średnicę 36 cm i wykonany jest z fluorku wapnia. Dla porównania, jeśli teleskop znajduje się w kosmosie, minimalny rozmiar obrazu gwiazdy można ograniczyć jedynie poprzez dyfrakcję, a zatem w ognisku na detektorze jego rozmiar jest taki sam, niezależnie od średnicy teleskopu, dla danej liczby F. Zatem na przykład prosta kamera spektrografowa zaprojektowana dla teleskopu o średnicy 1 m będzie działać z pełną wydajnością, jeśli zostanie użyta w połączeniu z teleskopem kosmicznym o średnicy 8 m. Dzięki temu bardziej wykonalne staje się wykorzystanie wydajnych spektrografów w gigantycznych teleskopach kosmicznych przyszłości, takich jak być może 100-metrowy teleskop zwierciadła ciekłego na Księżycu.

W przypadku obserwacji satelitów przywracane jest zerowe zniekształcenie poprzez usunięcie decentracji i pochylenia elementów. Gdyby teleskop został przeniesiony do Obserwatorium Cloudcroft na 31° szerokości geograficznej, zmniejszenie zniekształceń gwiazdowych w tym miejscu można by osiągnąć poprzez odpowiednią zmianę położenia elementów. Zaletą skanowania dryftu jest to, że różnice w czułości detektora piksel po pikselu są zmniejszone, ponieważ odpowiedź jest uśredniana dla wszystkich pikseli CCD w kolumnie. Sterowane teleskopy są czasami używane do skanowania dryfu poprzez śledzenie po wielkim okręgu z szybkością inną niż gwiazdowa i obracanie detektora. W tym przypadku efekty nieliniowe są zminimalizowane bez konieczności stosowania korektora asymetrycznego. Jednakże, ze względu na fizyczny ruch wymagany od kamery, długość toru wielkiego koła jest ograniczona. Obserwacje musiałyby zostać przerwane, gdy pozycja kamery jest ustawiona tak, aby podążała za różnymi torami wielkiego okręgu. Dla porównania LMT, czyli dowolny teleskop zatrzymany w zenicie, może integrować się w sposób ciągły z detektorem stacjonarnym.

Widmo widzialne każdego składnika (środkowa krzywa, górne panele) uzyskano poprzez obrotowe wygładzenie śladu słonecznego za pomocą odpowiedniego v sin i; cecha absorpcji w pobliżu 6339 Å jest nierozwiązanym bliskim połączeniem. Pionowa linia przerywana oznacza położenie spoczynkowe środkowej ostrej absorpcji. Dla przejrzystości przyjęto, że widmo pierwotne jest o 10% jaśniejsze niż widmo wtórne przy tej długości fali czerwonej (co odpowiada V ∿ 0,1 mag); widmo wtórne jest zacienione. Zwróć uwagę na wyblakły wygląd tego ostatniego. Kiedy oba widma zostaną połączone w celu uzyskania kompozytu na górze każdego panelu, ostre linie pierwotnego rozmywają się we względnym strumieniu około 2 razy i opadają na falujące tło zapewniane przez rozmazany obrotowo element wtórny. Nic dziwnego, że tak trudno było wyizolować wtórny udział w historycznych, zaszumionych widmach fotograficznych.

61 Cygni

Gwiazda 61 Cygni jest ważna ze względu na jej duży ruch własny, po raz pierwszy zmierzony w Obserwatorium w Palermo przez Giuseppe Piazziego (1746-1826). Gwiazda stała się popularnie nazywana "latającą gwiazdą Piazziego". Jej zmierzony roczny ruch własny wynosi 5,23″ jest nadal siódmą co do wielkości znaną gwiazdą i największą gwiazdą widzianą gołym okiem (pozorna jasność 4,8 mag). Ta gwiazda była również pierwszą, której roczna paralaksa została wiarygodnie określona przez Friedricha Bessela (1784-1846). Pomiar Bessela wynoszący 0,314″, wykonany w Königsberg za pomocą 6,25-calowego heliometru Fraunhofera w 1838 r., całkiem dobrze wypada w porównaniu ze współczesną wartością 0,286″. Oznaczenia paralaksy gwiazd wykonane w tym samym roku przez innych obserwatorów były znacznie mniej dokładne. Jest to jedenasta najbliższa gwiazda, znajdująca się w odległości 11,4 lat świetlnych. 61 Cygni jest również dobrze znanym systemem podwójnym, którego okres wynosi 653,3 lat. Jego składniki są

obecnie oddzielone o 30,3″ przy kącie położenia 150°. Główna gwiazda 61 Cyg A to pomarańczowy karzeł typu widmowego K5V o pozornej wielkości 5,20 i bezwzględnej 7,5. Jego towarzysz 61 Cyg B jest również pomarańczowym karłem typu widmowego K7V, o jasności pozornej 6,05 i jasności bezwzględnej 8,3. Układ ten jest uważany za najszerzej obserwowaną gwiazdę podwójną, uzupełnioną o kilka tysięcy obserwacji wizualnych ponad 34 000 klisz fotograficznych. Precyzyjne pomiary astrometryczne tych płyt wykazały, że układ ma co najmniej jeden niewidoczny składnik, uważany za planetę o masie podobnej do Jowisza i być może aż trzy, z okresami orbitalnymi od 5 do 12 lat.

Gromady Abella

Gromady Abella to najbardziej rzucające się w oczy skupiska galaktyk zidentyfikowane przez George′a Abella na płytach z pierwszego przeglądu fotograficznego wykonanego za pomocą TELESKOPU SCHMIDT na Mount Palomar w latach pięćdziesiątych XX wieku. Czasami termin gromady Abella jest używany jako synonim pobliskich, optycznie wybranych gromad galaktyk. George Abell stworzył katalog zawierający 2712 najbogatszych takich zgrupowań na niebie północnym, który później rozszerzono na niebo południowe. Nie będzie przesadą stwierdzenie, że całkowita próbka 4076 kandydatów na gromady na całym niebie zrewolucjonizowała badania wielkoskalowej struktury we Wszechświecie. Katalog Abella stworzył podstawę do pierwszych badań ilościowych najgęstszego składnika wielkoskalowej struktury we wszechświecie lokalnym. W ostatnich latach definicja próbek klastrów kandydujących z płyt do badań szerokiego pola została powtórzona za pomocą automatycznych maszyn do skanowania płyt. Pokazało to obiektywnie, że subiektywny czynnik

wizualnej selekcji Abella jest dość mały, przynajmniej dla bogatszych i bliższych gromad. Rzeczywistość kandydatów na gromady w katalogu Abella była przedmiotem pewnej debaty, dopóki obserwacje spektroskopowe dużej liczby galaktyk w kierunkach gromad Abella nie wykazały przekonująco, że tylko niewielka część bogatych gromad jest wynikiem przypadkowych superpozycji. Oznacza to, że bardzo duża część kandydatów na bogate gromady w katalogu sporządzonym przez Abella (lub, włączając gromady południowe, przez Abella, Corwina i Olowina) reprezentuje zwarte, zlokalizowane piki w przestrzennym rozmieszczeniu galaktyk, głównie z przesunięciami ku czerwieni mniejszym niż 0,2 i utrzymywane razem grawitacyjnie. Już w latach trzydziestych XX wieku Fritz ZWICKY doszedł do wniosku, że świetlista materia (tj. galaktyki) w gromadach stanowi tylko około 10% całkowitej masy gromady, z czego większość można zatem wykryć jedynie za pomocą jej grawitacji. Doprowadziło to do oszacowania całkowitej masy (zarówno widocznej, jak i

ciemnej materii) na różne sposoby. Najczęstsze z nich to prędkości galaktyk w gromadzie, ilość i temperatura gorącego (emitującego promieniowanie rentgenowskie) gazu oraz zniekształcenie obrazów galaktyk w odległości znacznie większej niż gromada przez soczewkowanie grawitacyjne. Przez długi czas kilka lepiej znanych gromad Abell, takich jak te w konstelacjach COMA BERENICES i PERSEUS, kształtowało naszą wizję klas bogatych, zaludnionych gromad. W tym schematycznym widoku bogate gromady są gładkimi, okrągłymi i zwirializowanymi strukturami. Ten wyidealizowany obraz współistniał ze świadomością, że istnieją znaczne różnice w różnych właściwościach gromad Abella. Doprowadziło to do wielu badań tych właściwości i korelacji między nimi, a także do kilku prób opisania powstawania i ewolucji bogatych klastrów. Obecnie zdano sobie sprawę, że klastry nadal tworzą się i ewoluują w obecnej epoce. Wśród właściwości gromad, które można badać i dla których dokonano teoretycznych przewidywań, są kształt 3D (a raczej

osiowe proporcje rozkładu galaktyk), skład populacji galaktyk (tj. frakcje galaktyk o różnych typach morfologicznych ), rozkłady jasności galaktyk, szczegółową dynamikę różnych klas galaktyk, dynamiczną podstrukturę i segregację oraz ułamek masy całkowitej składający się z materii barionowej (tj. "zwykłej" materii nukleonowej). Ważnym niedawnym osiągnięciem jest poszukiwanie i badanie gromad galaktyk w bardzo dużych odległościach (tj. przy dużych przesunięciach ku czerwieni), które są "przodkami" lokalnych bogatych gromad w katalogu Abella. W przypadku tych młodszych gromad z dużymi przesunięciami ku czerwieni gromady Abella służą jako lokalna, współczesna populacja referencyjna. Gromady Abella jako podzbiór całej populacji gromad Podczas poszukiwania kandydatów na gromady na płytach Palomar Sky Survey, Abell nie miał informacji o odległościach (lub przesunięciach ku czerwieni) galaktyk. Dlatego wykorzystał rozkład galaktyk w pozornej wielkości, aby wybrać te piki w rzutowanym rozkładzie galaktyk, które naj

prawdopodobniej odpowiadają przestrzennie zwartej strukturze. Przyjmując wielkość 10. najjaśniejszej galaktyki jako przybliżoną "świecę standardową", oszacowano przesunięcie ku czerwieni; daje to kąt określony przez ustalony rozmiar liniowy 1,5h-1 Mpc w odległości gromady (gdzie h jest wartością obecnego parametru Hubble′a, wyrażoną w jednostkach 100 km s-1 Mpc-1). W okrągłej aperturze o promieniu równym temu kątowi zliczono liczbę galaktyk o wielkości nie większej niż dwie magnitudo słabszej niż trzecia pod względem jasności galaktyka. Ostatecznie liczbę niepowiązanych galaktyk w aperturze (i do tej samej granicy jasności) oszacowano na podstawie gęstości galaktyk w polach tła bez oczywistych kandydatów na gromady. Skorygowana liczba galaktyk (liczba bogactw, tj. szacowana liczba członków w aperturze powyżej granicy jasności) ma niepewność około 17. Dlatego Abell uznał, że tylko gromady ze skorygowaną liczbą galaktyk wynoszącą co najmniej 50 zostały pobrane w obiektywny sposób z przesunięciami ku czerwieni wynoszącymi 0,1-0,2. W oryginalnym ("północnym") katalogu Abella 1682 z 2712 kandydatów na klastry ma liczbę co najmniej 50. Dolna granica bogactwa musi być stosowana, jeśli korzysta się z katalogu Abella do celów statystycznych. Oczywiście istnieje wiele mniej bogatych klastrów, ale przy większych odległościach przesunięcia ku czerwieni ich kontrast w stosunku do pola jest zbyt niski, aby umożliwić solidne zdefiniowanie statystycznie wiarygodnej próbki. W ostatnich latach obszerne badanie przesunięcia ku czerwieni (ESO Nearby Abell Cluster Survey) zostało przeprowadzone na blisko 6000 galaktyk w około 100 kandydatach na gromady (głównie z południowej części katalogu Abell, Corwin i Olowin) o bogactwie wynoszącym co najmniej 50 i szacowane przesunięcia ku czerwieni mniejsze niż 0,1. Zanieczyszczenie w tych przeglądach przesunięcia ku czerwieni przez galaktyki, które nie należą do głównej gromady, jest dalekie od pomijalnego, tj. około 25%. Jednak większość przeglądów przesunięć ku czerwieni zawiera przestrzennie zwartą gromadę, do której należy co najmniej 50% galaktyk ze zmierzonymi przesunięciami ku czerwieni. Tylko około 10% kandydujących gromad wydaje się być superpozycją dwóch prawie równie bogatych (ale stosunkowo ubogich) systemów przy różnych przesunięciach ku czerwieni wzdłuż tej samej linii widzenia. W przypadku systemów zwartych przestrzennie dyspersja prędkości wykazuje globalną korelację z liczbą bogactw (klastry o większej liczbie bogactw mają średnio większe dyspersje prędkości), ale korelacja jest bardzo szeroka (co najmniej współczynnik 2 w obu wielkościach). Można by sądzić, że niepewność oszacowanych wizualnie zliczeń bogactwa jest za to odpowiedzialna, ale szerokość relacji nie zmniejsza się, jeśli użyje się zliczeń bogactwa opartych na skanowaniu maszynowym zamiast oryginalnych. Dla próbki około 150 gromad Abella z przesunięciami ku czerwieni mniejszymi niż 0,15, masy klastrów obliczono na podstawie względnych prędkości i pozycji galaktyk, zakładając, że twierdzenie wirialne zachodzi w centralnych obszarach gromad. Masy klastrów dość dobrze korelują z dyspersją prędkości, ale rozkłady mas w różnych przedziałach zliczeń bogactwa wydają się w znacznym stopniu pokrywać. Dlatego zastosowanie limitu zliczania bogactwa do próbki gromad Abella (co jest konieczne ze względów praktycznych) indukuje dość rozproszony limit masy. Gromady, a raczej kandydaci na klastry, w katalogu Abella o bogactwie co najmniej 50, są zatem podzbiorem wszystkich klastrów w zakresie mas od około 4×1013 do 2×1015MM⊙. Jednak dla klastrów o rozkładzie prędkości co najmniej 800 km s-1 zasadniczo wszystkie zliczenia bogactwa są większe niż 50. Innymi słowy, wszystkie klastry o rozkładzie prędkości co najmniej 800 km s-1 są zawarte w próbce z graniczna liczba 50, a oszacowanie ich gęstości przestrzennej jest bezstronne. Gromady z pozornymi dyspersjami prędkości większymi niż około 1200 km s-1 okazują się albo superpozycjami, albo mają dużo dynamicznej podstruktury. Wraz z pojawieniem się przeglądów rentgenowskich całego nieba, takich jak te z misji EINSTEIN (HEAO-2) i ROSAT, stało się możliwe konstruowanie kompletnych próbek gromad, dla których strumień promieniowania rentgenowskiego z gorącego gazu w studni potencjału klaster jest większy niż wartość progowa. W ten sposób powstają katalogi klastrów, które zasadniczo różnią się od katalogu Abell, a tym samym są do niego komplementarne, chociaż w pewnym stopniu się pokrywają. Masa gazu rentgenowskiego jest na ogół co najmniej tak duża, jak masa gromad galaktyk, ale łączna masa tych dwóch składników barionowych wynosi zazwyczaj tylko 10-15% masy całkowitej. Kiedy całkowitą masę gromady można oszacować zarówno na podstawie kinematyki galaktyk, jak i temperatury i jasności w promieniach rentgenowskich, te dwa oszacowania ogólnie dość dobrze się zgadzają.

Właściwości populacji galaktyk w gromadach Abella

W przeszłości zaproponowano kilka schematów klasyfikacji klastrów Abella. Wszystkie z nich podsumowują w taki czy inny sposób rozmieszczenie galaktyk w gromadzie pod względem pozycji, wielkości lub typu morfologicznego lub dowolnej ich kombinacji. Przewidywany rozkład galaktyk ma wiele form i waha się między następującymi skrajnościami. Może występować centralna koncentracja jasnych galaktyk, na ogół wczesnego typu, tj. eliptycznych, a często jedną z nich jest galaktyka cD, tj. gigantyczna eliptyczna otoczona rozciągniętą otoczką. Na drugim biegunie znajdują się klastry, które nie mają wyraźnej koncentracji centralnej. W niektórych gromadach rozkład galaktyk jest dość gładki i generalnie gromady te zawierają stosunkowo niewiele galaktyk spiralnych. Kiedy frakcja galaktyk spiralnych jest duża, rozkład galaktyk jest generalnie mniej regularny. Względne frakcje galaktyk wczesnego i późnego typu są skorelowane z liczbą bogactw, co jest przejawem relacji morfologia-gęstość. Ta ostatnia pokazuje wyraźną korelację między względnymi frakcjami galaktyk eliptycznych, soczewkowatych (S0s) i spiralnych, a (lokalną) rzutowaną gęstością galaktyk (a zatem odległością promieniową). S0 mogą stanowić do 50% w centrum, z galaktykami eliptycznymi tuż za nimi i galaktykami spiralnymi około 10%. W zewnętrznych częściach galaktyki eliptyczne są prawie nieobecne, podczas gdy galaktyki spiralne mogą stanowić do 60%. Należy zauważyć, że są to wartości globalne: poszczególne klastry wykazują znaczny rozrzut wokół nich. Chociaż w znacznej części gromad Abell rozkład galaktyk nie jest bardzo regularny lub kołowo-symetryczny, zawsze można wyprowadzić uśredniony azymutalnie rzutowany profil gęstości liczbowej Σ(R), w którym R jest rzutowaną odległością od centrum gromady, tj. najkrótsza odległość między linią widzenia przez galaktykę a centrum gromady. Zaproponowano kilka wyrażeń do matematycznego opisu Σ(R), z których wszystkie mają trzy parametry. Są to centralna wartość Σ(R), tj. ΣR = 0), charakterystyczna długość Rc (odległość, przy której Σ(R) zmniejszyła się o zadany współczynnik, powiedzmy 2) i miarę spadku Σ(R) w częściach zewnętrznych (ogólnie nachylenie logarytmiczne ? Σ(R)). Ostatnio Σ(R) została wyprowadzona dla galaktyk o różnych typach morfologicznych w około 70 bogatych gromadach Abella. W poszczególnych gromadach liczba galaktyk określonego typu jest generalnie niewystarczająca, aby umożliwić dokładne oszacowanie trzech parametrów Σ(R). Odpowiednio łącząc dane dla wielu gromad można porównać reprezentacje Σ(R) dla galaktyk eliptycznych, S0, spiralnych i galaktyk z liniami emisyjnymi (głównie bardzo 'późne' spirale, takie jak Sc i S d, ze zjonizowanym gazem w ośrodku międzygwiazdowym). Innymi słowy, poświęcając szczegółowe właściwości poszczególnych klastrów, uzyskuje się obraz średnio bogatej gromady Abella. Wydaje się, że istnieje wyraźna korelacja między typem galaktyki a Σ(R): charakterystyczna długość Rc znacznie wzrasta od wczesnego do późnego typu galaktyki (od około 0,1 do 0,5 Mpc). Pokazuje to, że galaktyki eliptyczne są rzeczywiście znacznie bardziej skoncentrowane centralnie niż galaktyki spiralne, podczas gdy galaktyki linii emisyjnych tworzą najbardziej rozległą populację. Tym różnicom muszą towarzyszyć różnice w kinematyce galaktyk różnych typów, ponieważ wszystkie klasy galaktyk poruszają się w tym samym potencjale gromady, który w większości determinowany jest przez ciemną materię. Takie różnice kinematyczne są rzeczywiście obserwowane: eliptyczne i S0 wykazują najmniejsze rozproszenie składowej ich prędkości w linii wzroku, a rozproszenie to zmienia się nieznacznie wraz z rzutowaną odległością od środka. Spirale, a w szczególności galaktyki z liniami emisyjnymi, mają większą dyspersję prędkości (nawet o 20-30%), która wyraźnie maleje wraz z większymi rzutowanymi odległościami. Właściwie kinematyka linii emisji galaktyk wskazuje, że nie przeszły one jeszcze przez gęste jądra centralne, co jest prawdopodobnie powodem, dla którego nie straciły one jeszcze gazu emitującego linie w spotkaniach z innymi galaktykami. Łącząc przewidywane rozkłady galaktyk z kinematyką, można oszacować rozkład masy całkowitej (widocznej i ciemnej) za pomocą równania dynamiki gwiazd Jeansa. Porównując rozkład ciemnej materii z jasnością galaktyk, można w zasadzie badać zmiany tak zwanego stosunku masy do światła wraz z odległością od centrum gromady. Może to dać wskazówki dotyczące szczegółów procesu powstawania, takich jak skutki zderzeń galaktyk, rola halo ciemnej materii w galaktykach itp.

Gromady Abella jako sondy kosmologiczne

Kilka właściwości obserwacyjnych gromad Abell zostało wykorzystanych do ograniczenia teorii powstawania wielkoskalowych struktur we Wszechświecie i parametrów w tych teoriach. Właściwości te obejmują rozkład przestrzenny klastrów Abella, ich kształty i masy. Wszystkie one na różne sposoby niosą ze sobą informacje o tym, w jaki sposób największe, dobrze rozwinięte struktury we wszechświecie powstały poprzez wzrost początkowych fluktuacji gęstości materii. Przestrzenny rozkład klastrów Abella przeanalizowano za pomocą dwupunktowej funkcji korelacji ξ(r), tj. ułamka par klastrów z pewną separacją, przekraczającą oczekiwaną liczbę par dla rozkładu losowego, którą wyprowadzono dla skupiska o różnym bogactwie. Ogólnie rzecz biorąc, funkcja korelacji ma postać potęgową: ξ(r) = (r/r0)-γ ; wykładnik γ (około 2) nie wydaje się zależeć od granicznej liczby bogactw, ale wartość długości korelacji r0 tak, i jest większa dla bogatszych klastrów (z charakterystyczną wartością około 20 Mpc). W zasadzie dane te pozwalają wyprowadzić wartość gęstości kosmologicznej, jak również amplitudę widma fluktuacji. Innym aspektem rozmieszczenia bogatych gromad Abella jest to, że generalnie znajdują się one w wierzchołkach, w których spotykają się arkusze i włókna w ogólnym rozmieszczeniu galaktyk. Dlatego rozkład bogatych klastrów był czasami porównywany z rozkładem wierzchołków w tak zwanych teselacjach Woronoja, które są geometrycznymi podziałami przestrzeni. Kształty gromad Abella zostały wyprowadzone z przewidywanych rozkładów galaktyk. Korzystając z pozycji galaktyk niezależnie od typu galaktyk, można obliczyć pozorną eliptyczność gromady. Ogólnie rzecz biorąc, bogatsze klastry są mniej wydłużone niż mniej bogate. Pozorne eliptyczności dla próbki gromady około 100 północnych gromad Abella sugerują, że wydłużone gromady są raczej wydłużone (podobne do cygar) niż spłaszczone. Porównanie tych danych z wynikami numerycznych obliczeń N-ciałowych może zawęzić teorie powstawania struktur. Pełny rozkład mas ograniczonej objętościowo próbki klastrów Abella (tj. jej kształtu i normalizacji) może również dostarczyć informacji dla teorii tworzenia struktur kosmologicznych. Ponieważ próbka gromad Abella o granicznej liczbie bogactw wynoszącej 50 ma raczej źle zdefiniowaną kompletność przy mniejszych masach, należy ograniczyć porównanie między obserwacjami i przewidywaniami do najbardziej masywnych gromad, dla których katalog Abella jest kompletny. Uzyskanie niezależnych informacji dla kilku parametrów w teoriach formacji, które wpływają na właściwości najbardziej masywnych struktur, nie jest wcale trywialne. Wydaje się jednak, że istnieje ogólna zgoda co do tego, że te ostatnie są bardziej zrozumiałe we wszechświecie, w którym gęstość materii jest znacznie mniejsza niż gęstość krytyczna.

Widmo absorpcyjne

Wzór ciemnych linii lub pasm nałożonych na widmo ciągłe. Kiedy ciągłe widmo promieniowania (szeroki zakres długości fal) przechodzi przez ośrodek materialny (na przykład chłodny gaz o niskim ciśnieniu), przy pewnych określonych długościach fal zachodzi selektywna absorpcja. Prowadzi to do serii spadków intensywności (linii absorpcyjnych), które w widocznym obszarze widma wyglądają jak ciemne linie na jasnym tle "tęczowego" pasma kolorów, które obejmuje widmo ciągłe. Fotony promieniowania elektromagnetycznego mogą być pochłaniane przez wzbudzenie radiacyjne, proces, który zachodzi, gdy elektron na jednym z niższych poziomów energetycznych atomu lub jonu absorbuje foton o energii dokładnie równej różnicy energii między tym poziomem a jednym z wyższych poziomów dozwolonych poziomów i w rezultacie przeskakuje (dokonuje "przejścia w górę") z poziomu niższego na wyższy. Ponieważ energia fotonu jest odwrotnie proporcjonalna do długości fali, im większa przerwa energetyczna, tym krótsza długość fali promieniowania,

które jest absorbowane, gdy elektron dokonuje określonego przejścia. Elektron zwykle nie pozostaje długo na poziomie wzbudzonym (zwykle 10-8 s). Kiedy spada ponownie, emituje foton lub fotony, które mogą mieć taką samą długość fali jak ta, która została pierwotnie wchłonięta, ale nie muszą (w zależności od tego, czy spada bezpośrednio do swojego pierwotnego poziomu, czy też opada w serii mniejszych kroków). Jeśli spada w serii kroków, z których każdy odpowiada emisji fotonu o niższej energii (i większej długości fali) niż ten, który został pierwotnie zaabsorbowany, całkowita liczba fotonów pierwotnej energii zostanie zmniejszona, a widmo zostanie wyczerpany przy długości fali wejściowej. Co więcej, chociaż wszystkie fotony wejściowe poruszały się zasadniczo w tym samym kierunku (od źródła do obserwatora), ponownie wyemitowane fotony oddalają się w przypadkowych kierunkach. W konsekwencji do obserwatora dociera znacznie mniej fotonów o długości fali absorpcji niż fotonów o innych długościach fal. Powstała

linia absorpcyjna jest ciemniejsza niż sąsiednia część widma ciągłego, ale ponieważ niektóre fotony o tej długości fali docierają do obserwatora, nie jest całkowicie czarna. Ponieważ każde dozwolone przejście odpowiada pochłanianiu światła o określonej długości fali, atomy lub jony określonego pierwiastka wytwarzają linie absorpcyjne przy wielu różnych długościach fal, przy czym każdy pierwiastek chemiczny ma swój własny charakterystyczny wzór linii absorpcyjnych "odcisków palców". Linie o najkrótszej długości fali odpowiadają największym przerwom energetycznym (tj. przejściom z najniższego, "podstawowego" poziomu atomu lub jonu). Jeśli elektron pochłonie foton o energii przekraczającej energię jonizacji (lub "potencjał jonizacji"), zostanie usunięty z atomu. Widmo absorpcyjne określonego rodzaju atomu składa się z kilku serii linii odpowiadających różnym dozwolonym przemianom, przy czym granica krótkofalowa szeregu odpowiada energiom fotonów, powyżej których zachodzi jonizacja. Ponieważ fotony jonizujące

mogą w zasadzie mieć dowolną wartość energii powyżej energii jonizacji, absorpcja może zachodzić w ciągłym zakresie długości fal, krótszym niż granica serii. Absorpcja tego rodzaju nazywana jest kontinuum absorpcji. Wyraźność ("siła") danej linii zależy od liczby atomów odpowiedniego pierwiastka chemicznego, które mają elektrony rezydujące na poziomie energii, od którego następuje odpowiednie przejście w górę (stopień wzbudzenia). To z kolei zależy od obfitości danego pierwiastka chemicznego (względny udział tego pierwiastka w substancji pochłaniającej) oraz od szeregu innych czynników, w szczególności od temperatury (im wyższa temperatura, tym większy udział elektronów w stanach wzbudzonych). Oprócz wytwarzania absorpcji poprzez przemiany elektronowe (takie jak atomy i jony), cząsteczki mogą również absorbować (lub emitować) promieniowanie, zmieniając swoje stany wibracyjne (ich składowe atomy wibrują względem siebie) lub obracając się (cząsteczka mająca kształt fizyczny , może obracać się wokół określonej

osi). Widma absorpcji molekularnej są złożone, a ich różne linie często łączą się w szersze pasma.

Akrecja

Proces, w którym ciało niebieskie zwiększa swoją masę poprzez agregację mniejszych obiektów, które się z nim zderzają. Kilka typów obiektów rośnie przez akrecję. W gwiazdach podwójnych, w których zachodzi wymiana masy, jeden członek rośnie kosztem drugiego; czarne dziury, w tym supermasywne czarne dziury, o których uważa się, że są obecne w aktywnych jądrach galaktyk, również zwiększają swoją masę poprzez akrecję. W obu przypadkach materia gromadzi się poprzez dysk akrecyjny krążący wokół obiektu akrecyjnego. Proces ten jest szczególnie ważny w procesie formowania się planet. Ziarna pyłu w dysku protoplanetarnym (lub proplydzie) wokół młodej gwiazdy zderzają się i łączą, stopniowo budując większe obiekty, które z kolei zderzają się i łączą. Obiekty akreowane w tej początkowej fazie formowania się planet, a ich rozmiary mieszczą się w przedziale od milimetrów do dziesiątek kilometrów, nazywane są planetozymalami. Gdy rozmiar obiektu można zmierzyć w kilometrach, jego własna grawitacja staje się czynnikiem akrecji. Kolizyjne łączenie się planetozymali umożliwia budowanie większych ciał, które nazywane są protoplanetami, obiektami o długości co najmniej tysiąca kilometrów. Późniejsza ewolucja protoplanet przebiega przez wzajemne zderzenia o wzrastającej sile i narastanie fragmentów powstałych w tych zderzeniach. Ciała pozostawione na orbicie gwiazdy po zakończeniu tej ostatniej fazy bombardowania nazywane są planetami.

Dyski akrecyjne

Przez akrecję rozumie się w astrofizyce akumulację materii na ciężki obiekt pod wpływem jego grawitacji. Obiektem może być na przykład gwiazda, czarna dziura lub gwiazda neutronowa. Większość obiektów tego typu jest dość odizolowana, bez dużej ilości gazu wokół, który mógłby zostać wciągnięty przez ich grawitację. W związku z tym zdecydowana większość gwiazd nie wykazuje żadnych oznak akrecji, podczas gdy większość gwiazd neutronowych i czarnych dziur w naszej galaktyce jest z tego powodu nieobserwowalna. Dyski akrecyjne, choć nieco egzotyczne w porównaniu ze zwykłymi gwiazdami lub galaktykami, przyciągają uwagę, ponieważ biorą udział w wielu bardzo widocznych zjawiskach. Obejmują one formowanie się naszego układu planetarnego i pierścieni Saturna, rentgenowskie układy podwójne w naszej galaktyce i skolimowane dżety z protogwiazd i akreujących czarnych dziur. Obserwowalne efekty akrecji mogą wahać się od skromnych do dość dramatycznych. Zależy to od ilości masy narastającej w jednostce czasu, ale jeszcze bardziej od głębokości studni potencjału pola grawitacyjnego akretora. Najprostszym modelem akrecji byłaby swobodna cząstka spadająca promieniowo do akretera z dużej odległości. Jeśli zaczyna się od spoczynku w nieskończoności, dociera do powierzchni R akretera o masie M z prędkością ucieczki ve = (GM/R)1/2. Możemy to również zapisać jako ve/c = (rg/2R)1/2, gdzie rg = 2GM/c2 = 2,8M/M⊙ km to promień Schwarzschilda o masie M. Dla gwiazdy neutronowej o M = 1,4M⊙ i R = 10 km, na przykład cząstka dotarłaby do powierzchni z prędkością około 30% prędkości światła. Akrecji na obiekty zwarte, w których M/R jest duże, towarzyszy zatem uwolnienie dużych ilości energii. Cząstka swobodna przyciągana do zwartego obiektu z dużej odległości ma tylko niewielką szansę na trafienie. Jeśli jego początkowy ruch nie jest skierowany bardzo dokładnie na obiekt, po prostu zatoczy orbitę i powróci na tę samą dużą odległość. Innymi słowy, przekrój poprzeczny dla akrecji przez wolne cząstki jest mały. Ten sam efekt odgrywa rolę, gdy rozważamy bardziej realistyczny przypadek akrecji gazu i nazywa się go "problemem momentu pędu", omówionym poniżej. Gaz akrecyjny może być na przykład dostarczany przez obłok protogwiazdy w przypadku rosnącej protogwiazdy lub przez gwiazdę towarzyszącą w układzie podwójnym. Jeśli gwiazda akreująca jest gwiazdą neutronową lub czarną dziurą, taki układ podwójny nazywa się UKŁADEM DWUKŁADOWYM PROMIENIOWANIEM RENTGENOWSKIM; jeśli jest to biały karzeł, układ podwójny nazywa się KATAKLIZMOWYM BINARNYM. Wreszcie akrecja jakiejś formy materii międzygwiezdnej na masywną czarną dziurę w jądrze galaktyki tworzy AKTYWNE JĄDRO GALAKTYCZNE (AGN). Prawie wszystkie dyski są tak małe, jak widać z Ziemi, że ich geometrię można wywnioskować jedynie pośrednio. Dyskami, które można obserwować bezpośrednio, są nasz układ planetarny, pierścienie Saturna i galaktyki spiralne. Żaden z nich nie jest jednak typowy dla gazowych dysków akrecyjnych. Nasz Układ Słoneczny jest tylko stałą pozostałością dysku akrecyjnego, który istniał podczas jego formowania. W przypadku pierścieni Saturna cząsteczki tworzące pierścienie również zachowują się bardziej jak cząstki swobodne niż jak gaz. Dyski w galaktykach spiralnych są znacznie bardziej skomplikowane niż dyski gazowe. Ponadto dyski galaktyczne nie są wystarczająco stare, aby od czasu ich powstania nagromadziły się w galaktycznym jądrze. Najlepszą perspektywą na bezpośrednie obserwowanie dysków akrecyjnych są protogwiazdy. Są to największe dyski pod względem średnicy kątowej widziane z Ziemi, a dzięki obecnie rozwijającym się obrazom w podczerwieni i falach milimetrowych o wysokiej rozdzielczości możliwe będą szczegółowe obserwacje ich struktury. Duże "proplydy" (dyski protoplanetarne) zostały sfotografowane w zakresie optycznym przez Kosmiczny Teleskop Hubble′a;. W przypadku układów podwójnych, informacji o rozmiarze, grubości i temperaturze dysku dostarczają zaćmienia. Jeśli układ podwójny jest zorientowany w taki sposób, że Ziemia znajduje się blisko swojej płaszczyzny orbity, dysk i dostarczająca masy gwiazda wtórna zaćmiewają się regularnie, gdy składniki krążą wokół siebie. Kształt krzywej blasku przy różnych długościach fal można następnie wykorzystać do określenia właściwości dysku, takich jak jego rozmiar i temperatura

Temperatury akrecji

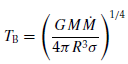

Charakterystyczną temperaturą w problemach akrecyjnych jest temperatura wirialna,

Tv = |Φ |/R (1)

gdzie R = 8,314 × 107 erg g-1 K-1 mol-1 jest molową stałą gazową Φ głębokością studni potencjału. W odległości r od masy punktowej w grawitacji newtonowskiej Φ = ?GM/r. Gdyby cała energia kinetyczna uzyskana podczas wpadania do studni potencjału została rozproszona w energię wewnętrzną (ciepło), gaz osiągnąłby temperaturę rzędu Tv. Dla gwiazdy neutronowej Tv ∼2×1012 K, co odpowiada średniej energii cieplnej protonu rzędu 1GeV. Promieniowanie faktycznie obserwowane z systemów akrecyjnych wskazuje na znacznie niższe temperatury. Dzieje się tak dlatego, że plazma termiczna w tej temperaturze emituje energię z ogromną szybkością, znacznie większą niż może być dostarczona przez opadający gaz. Zamiast Tv gaz osiada w niższej temperaturze, tak że rozproszona energia jest z grubsza równoważona przez energię traconą przez promieniowanie. Drugą charakterystyczną temperaturę uzyskuje się przy założeniu, że promieniowanie emitowane jest jakby przez ciało doskonale czarne z powierzchni akreującego obiektu. Przyrównując jasność L = 4πr2σT4 ciała doskonale czarnego o promieniu R i temperaturze TB do energii generowanej przez akrecję z szybkością ˙M (masa na jednostkę czasu) otrzymujemy

gdzie σ = 5,6692 × 10?5 erg cm?2 K?4 s?1 jest stałą w prawie Stefana-Boltzmanna. Rzeczywiste temperatury różnią się od tego, ponieważ emitowane widmo różni się od widma ciała doskonale czarnego, powierzchnia emitująca nie jest równa powierzchni obiektu akrecyjnego lub, w przypadku czarnych dziur, większość energii akrecyjnej jest pochłaniana przez dziurę, a nie niż być napromieniowanym. Mimo to T>B często zapewnia dobrą kolejność i wielkość dla obserwowanych temperatur. Powodem jest to, że w takich przypadkach gaz akrecyjny jest optycznie gęsty, więc w wyniku powtarzających się procesów emisji i absorpcji fotonów energia akrecji jest ponownie przetwarzana na coś w rodzaju widma ciała doskonale czarnego. Dla zmiennych kataklizmicznych, protogwiazd i AGN, T>B ∼ 104-105 K, dla rentgenowskich układów podwójnych około 107K, co odpowiada energii fotonów odpowiednio 1-10 eV i 1 keV. Mogą jednak również zachodzić optycznie cienkie procesy akrecji , wytwarzające fotony o znacznie wyższych energiach.

Ciśnienie promieniowania i granica Eddingtona

Fotony uwalniane przez akreujący obiekt wywierają siłę na akreujący gaz. Poprzez rozpraszanie (lub absorpcję i reemisję) na atomie, jonie lub elektronie, zewnętrzny kierunek fotonu zmienia się na bardziej losowy. Pęd fotonów na zewnątrz jest w ten sposób przenoszony na gaz: promieniowanie wywiera siłę skierowaną na zewnątrz. Jeśli F = L/4π?r2 jest strumieniem energii radiacyjnej w odległości r, a κ nieprzezroczystością gazu (rozpraszanie plus absorpcja), przyspieszenie wywołane tą siłą wynosi grad = Fκ/c. Ta siła jest po prostu równoważona przez przyspieszenie grawitacyjne w kierunku g = GM/r2, gdy jasność L ma wartość zwaną granicą Eddingtona lub jasnością Eddingtona:

LE = 4πGMc/κ. (3)

Stałe źródło fotonów, związane grawitacją, nie może mieć jasności znacznie przekraczającej tę granicę. Przy większej jasności atmosfera źródła jest wydmuchiwana przez promieniowanie (dzieje się tak np. podczas wybuchu NOVA). Wartość jasności Eddingtona zależy od nieprzezroczystości gazu, a tym samym od jego stanu jonizacji. To zależy od masy źródła, ale nie od jego wielkości. W pobliżu zwartego obiektu w rentgenowskim układzie podwójnym gaz jest prawie całkowicie zjonizowany, zwykle o normalnym składzie gwiazdowym, a dominującym procesem promieniowania jest rozpraszanie elektronów, z nieprzezroczystością κ ∼ 0,3 cm2g-1. Granica Eddingtona wynosi zatem

LE ≈ 1,5 × 1038M/M⊙ erg s-1 (4)

W przypadku gwiazdy neutronowej o wielkości 1,4 M⊙ jest to jasność około 50 000 razy większa od Słońca. Jeśli ta jasność jest generowana przez akrecję, przyrównanie jej do energii akrecji określa współczynnik akrecji Eddingtona ˙

ME = 4πcR/κ (5)

lub około 1,5 × 10-8M⊙ yr-1 dla gwiazdy neutronowej o promieniu 10 km. Gwiazda neutronowa nie może akreować znacznie więcej. Narastające ciśnienie promieniowania zapobiegłoby dalszej akrecji, a gaz gromadziłby się w rozszerzonej atmosferze wokół gwiazdy, zamiast osiadać na powierzchni gwiazdy neutronowej. (Przy założeniu, że promieniowanie pochodzi tylko od fotonów: przy dostatecznie wysokiej temperaturze i gęstości straty energii przez neutrina stają się istotne.) Szybkość akrecji na czarną dziurę może być znacznie większa niż ˙ME. Atmosfera otaczająca dziurę nie jest podtrzymywana u podstawy, ale przepływa przez horyzont. W procesie zabiera ze sobą fotony uwięzione w gazie. W zależności od gęstości takiej atmosfery tempo akrecji może być dowolnie wysokie. Jasność widziana z Ziemi nie staje się jednak dużo większa niż LE.

Dyski

Transfer masy w systemie binarnym

Jako przykład formowania się dysku akrecyjnego rozważ układ podwójny, w którym jedna z gwiazd jest wystarczająco duża, aby wypełnić płat Roche′a, a druga jest gwiazdą zwartą (biały karzeł, gwiazda neutronowa lub czarna dziura). Gwiazda wypełniająca płat Roche′a nazywana jest drugorzędną, ponieważ jest mniej masywną gwiazdą w takich układach podwójnych. Masa wypływa z wtórnego w wewnętrznym punkcie Lagrange′a L1. Orbita hipotetycznej swobodnej cząstki z tego punktu jest pokazana na rycinie 3. Z wyjątkiem punktu bezpośrednio w L1, prędkość orbitalna jest bardzo duża w porównaniu z prędkością dźwięku gazu. W konsekwencji jego tor jest prawie balistyczny, tj. zbliżony do toru cząstki swobodnej. Ponieważ jednak chmury gazu nie mogą przepływać przez siebie, przepływ balistyczny ustaje w pierwszym punkcie przecięcia orbity. Naddźwiękowy względny ruch dwóch części strumienia gazu jest tutaj rozpraszany przez fale uderzeniowe, które ogrzewają gaz i odchylają strumień. Dalsza ewolucja strumienia zależy od dodatkowych czynników fizycznych, takich jak szybkość, z jaką gaz może się ochładzać. Przykład tego, jak może wyglądać strumień po kilku okresach orbitalnych układu podwójnego, pokazano na rycinie 4. Gaz na orbicie zgromadził się w pierścieniu; nowo przybywający gaz jest wprowadzany do pierścienia przez system fal uderzeniowych. Silnie niekołowy ruch gazu ustabilizował się na spokojniejszej orbicie kołowej; większość energii rozproszonej w procesie została wypromieniowana. Pomijając zakłócenia powodowane przez uderzający strumień i przy braku sił lepkości, gaz może krążyć po takich okrągłych orbitach w nieskończoność.

"Problem momentu pędu"

W procesie osadzania się na orbicie kołowej duża część energii jest rozpraszana, ale moment pędu gazu wokół pierwotnego nie zmienił się (pomijając poprawki spowodowane przyciąganiem grawitacyjnym wtórnego). Ponieważ orbita kołowa ma najniższą energię dla danego momentu pędu, gaz może zanurzyć się głębiej w potencjale grawitacyjnym i akreować na pierwotną tylko wtedy, gdy może stracić trochę momentu pędu. Znalezienie procesu, w którym odbywa się to w rzeczywistych układach, nazywa się problemem momentu pędu. Zilustrowaliśmy to tutaj na przykładzie transferu masy w układzie podwójnym, ale ten sam problem pojawia się w przypadku formowania się gwiazd z obłoków międzygwiazdowych lub akrecji gazu na masywnych czarnych dziurach w AGN. W tych przypadkach początkowy moment pędu spowodowany przypadkowy ruch obłoków gazu jest o wiele rzędów wielkości większy, niż może pomieścić akreujący obiekt. Zamiast akrecji bezpośrednio, gaz tworzy dysk, działając jak tymczasowa "orbita parkingowa". Orientacja dysku jest określona przez kierunek wektora całkowitego momentu pędu chmur, podczas gdy czas potrzebny na spiralne przejście gazu przez dysk zależy od procesów rozwiązujących problem momentu pędu.

Lepkie dyski

W wielu przypadkach (nowe karłowate i transjenty rentgenowskie) akrecja na zwarty obiekt ma charakter epizodyczny, w postaci rozbłysków. Rozpad takiego wybuchu dostarcza pewnych informacji na temat czasu akrecji, to znaczy czasu, jaki zajmuje gazowi spiralne przejście od gwiazdy drugorzędnej do akrecyjnej gwiazdy pierwotnej. Na przykład w przypadku nowych karłowatych czas ten wynosi kilka dni, co pokazuje, że proces przenoszenia momentu pędu pozwala na akrecję w ciągu kilku dni lub mniej masy, która jest zaangażowana w wytwarzanie wybuchu. Chociaż rzeczywiste liczby zależą od modelu, obserwacje te wskazują, że transport momentu pędu jest o 12-15 rzędów wielkości bardziej wydajny niż oczekiwano na podstawie naturalnej lepkości gazu. Proces odpowiedzialny za przenoszenie momentu pędu w dyskach nie jest do końca znany. W obliczu tej niepewności teoria dysków akrecyjnych przyjmuje arbitralne założenie dotyczące procesu transportu momentu pędu. Zakłada się, że dysk zachowuje się w efekcie jak płyn o bardzo dużej

lepkości. Taka zwiększona lepkość rzeczywiście rozwiązuje problem momentu pędu. Jako eksperyment myślowy rozpocznij od pierścienia gazu krążącego w pewnej odległości od źródła potencjału grawitacyjnego. Lepkie naprężenie między sąsiednimi orbitami obracającymi się z nieco inną prędkością powoduje, że pierścień rozszerza się zarówno na zewnątrz, jak i do wewnątrz, tworząc dysk. To rozprzestrzenianie się ma niezwykłą właściwość: jeśli jest wystarczająco dużo czasu, prawie cała masa gromadzi się na centralnym obiekcie. Niewielka ilość masy w zewnętrznych częściach dysku rozszerza się w nieskończoność, przenosząc prawie cały moment pędu pierwotnego pierścienia. Czas rozprowadzenia na określoną odległość jest odwrotnie proporcjonalny do lepkości. Charakterystyczną prędkością w dysku jest izotermiczna prędkość dźwięku cs = (RT )1/2, gdzie T jest temperaturą w płaszczyźnie środkowej dysku (powierzchnie są chłodniejsze). Częstotliwością charakterystyczną jest częstotliwość orbitalna Ω.

Nieznaną lepkość dysku ν można następnie zmierzyć za pomocą bezwymiarowej lepkości α, określonej przez

ν = αc2s/Ω . (6)

Tam, gdzie dostępne są wskazania obserwacyjne, takie jak czas zaniku wybuchu, wskazują one lepkości w zakresie α = 10-3-1. Takie wartości są następnie wykorzystywane przy dokonywaniu teoretycznych szacunków struktury dysków akrecyjnych. Założenie, że procesy transportu momentu pędu można przedstawić równaniem (6), gdzie α jest czymś rzędu jedności, nazywa się α-lepkością założenia.

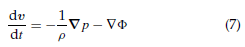

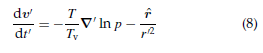

Cienkie dyski

Dyski akrecyjne są zwykle chłodne, ponieważ czasy akrecji są długie i jest wystarczająco dużo czasu, aby wypromieniować rozproszoną energię grawitacyjną. Jeśli są chłodne, wpływ ciśnienia gazu jest niewielki. Aby to zobaczyć, rozważmy równanie ruchu gazu doskonałego w potencjale grawitacyjnym o masie punktowej M, Φ = ?GM/r:

gdzie v to prędkość, ρ gęstość masy, a p ciśnienie gazu. W odległości r0 charakterystyczna skala czasu t0 jest odwrotnością częstotliwości Keplera, t0 = Ω

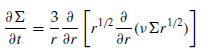

gdzie  jest wektorem jednostkowym w kierunku promieniowym, a Tv temperaturą wirialną wprowadzoną powyżej. Dla procesów zachodzących w skali długości r0 i skali czasu t0 wyrazy w tym równaniu są rzędu jedności, z wyjątkiem członu ciśnienia, który obejmuje współczynnik T/Tv. T/Tv jest rzędu jedności, jeśli cała rozproszona energia pozostaje w gazie, ale gdy chłodzenie jest skuteczne, może być bardzo mała. Składnik ciśnienia jest wtedy mały, a gaz przepływa balistycznie w potencjale . Dysk z T/Tv << 1 obraca się w przybliżeniu po kołowych orbitach Keplera. Ruch orbitalny jest naddźwiękowy, z liczbą Macha M = Ωr/cs ∼ (Tv/T )1/2. Grubość dysku oblicza się, biorąc pod uwagę pionowy rozkład gazu na pewnej odległości r0, zakładając, że znajduje się on w równowadze hydrostatycznej w ramie obracającej się z prędkością keplerowską Ω(r0). Gaz izotermiczny j∼est następnie rozprowadzany na wysokości z nad płaszczyzną orbity jako ρ ˜ exp[?1/2(z/H)2], gdzie H jest wysokością skali, H = r0(T /Tv)1/2 = cs/Ω . Jeśli straty promieniowania są małe, dysk jest gorący, a współczynnik kształtu H/r0 jest rzędu jedności. Z drugiej strony wydajnie promieniujące dyski są chłodne i geometrycznie cienkie, H/r << 1. Przy założeniu H/r << 1 równania hydrodynamiczne dla osiowosymetrycznego, płaskiego, lepkiego dysku są proste. Do najniższego rzędu radialne równanie ruchu redukuje się do v? = Ωr. Azymutalne równanie ruchu można połączyć z równaniem ciągłości w jedno równanie rządzące gęstością powierzchniową

jest wektorem jednostkowym w kierunku promieniowym, a Tv temperaturą wirialną wprowadzoną powyżej. Dla procesów zachodzących w skali długości r0 i skali czasu t0 wyrazy w tym równaniu są rzędu jedności, z wyjątkiem członu ciśnienia, który obejmuje współczynnik T/Tv. T/Tv jest rzędu jedności, jeśli cała rozproszona energia pozostaje w gazie, ale gdy chłodzenie jest skuteczne, może być bardzo mała. Składnik ciśnienia jest wtedy mały, a gaz przepływa balistycznie w potencjale . Dysk z T/Tv << 1 obraca się w przybliżeniu po kołowych orbitach Keplera. Ruch orbitalny jest naddźwiękowy, z liczbą Macha M = Ωr/cs ∼ (Tv/T )1/2. Grubość dysku oblicza się, biorąc pod uwagę pionowy rozkład gazu na pewnej odległości r0, zakładając, że znajduje się on w równowadze hydrostatycznej w ramie obracającej się z prędkością keplerowską Ω(r0). Gaz izotermiczny j∼est następnie rozprowadzany na wysokości z nad płaszczyzną orbity jako ρ ˜ exp[?1/2(z/H)2], gdzie H jest wysokością skali, H = r0(T /Tv)1/2 = cs/Ω . Jeśli straty promieniowania są małe, dysk jest gorący, a współczynnik kształtu H/r0 jest rzędu jedności. Z drugiej strony wydajnie promieniujące dyski są chłodne i geometrycznie cienkie, H/r << 1. Przy założeniu H/r << 1 równania hydrodynamiczne dla osiowosymetrycznego, płaskiego, lepkiego dysku są proste. Do najniższego rzędu radialne równanie ruchu redukuje się do v? = Ωr. Azymutalne równanie ruchu można połączyć z równaniem ciągłości w jedno równanie rządzące gęstością powierzchniową

(9)

(9)

Zgodnie z oczekiwaniami równanie to jest typu dyfuzyjnego. Pokazuje, że dla chłodnego dysku wszystkie czynniki fizyczne wpływające na ewolucję dysku wchodzą tylko przez lepkość ?. Ta lepkość zawiera oczywiście również większość założeń dotyczących nieznanych procesów. Zwykle potrzebne są dodatkowe równania, aby określić, w jaki sposób chłodzenie radiacyjne wpływa na strukturę temperatury dysku, od której zależy ?. Dla stałej akrecji i niezbyt blisko centralnego obiektu, szybkość akrecji jest związana z lepkością o ˙

M ≈ 3πνΣ . (10)

Wysoka lepkość implikuje niską gęstość powierzchniową, ponieważ masa akrecyjna spędza niewiele czasu w dysku. Charakterystyczny czas ta dla gazu orbitującego w odległości r do akrecji to lepka skala czasu,

W przypadku chłodnych dysków jest to dużo w porównaniu z orbitalną skalą czasu. Z drugiej strony, długa skala czasowa oznacza, że dysk ma dużo czasu na ochłodzenie przez promieniowanie, więc w mechanizmie, który ustala temperaturę dysku, występuje pewna kolistość. W danej sytuacji (masa centralna, odległość) o temperaturze dysku decyduje szybkość przyrostu masy i dominujący proces chłodzenia. W niektórych przypadkach dyski mogą istnieć w jednym z dwóch stabilnych, stale akreujących stanów: chłodnego z długimi czasami akrecji i gorącego z krótkimi czasami akrecji. W innych przypadkach okazuje się, że modele dysków są niestabilne dla pewnych szybkości przenoszenia masy, oscylując między stanami wysokiej i niskiej akrecji. Szczegóły procesów chłodzenia określają, kiedy takie wielokrotne stany akrecji istnieją (patrz "Procesy radiacyjne, akrecja dwutemperaturowa" poniżej).

Niestabilność dysku

Pionowa struktura dysku jest zdeterminowana potrzebą transportu lepko rozproszonej energii do powierzchni promieniujących. Dla danej gęstości powierzchniowej Σ ta struktura określa temperaturę i lepkość dysku. W warunkach, w których proces transportu energii zmienia się szybko wraz z temperaturą, naprężenie lepkie ?Σ może zależeć niemonotycznie od powierzchniowej gęstości masy, w postaci "krzywej S", jak pokazano na rycinie 5. Jeśli średnia szybkość akrecji, która jest narzucona (na przykład przez gwiazdę wtórną przenoszącą masę) mieści się w zakresie, w którym Σ maleje wraz ze wzrostem v Σ (porównaj równanie (10)), dysk jest niestabilny. Zamiast równomiernej akrecji, wykonuje cykl graniczny, naprzemiennie między stanami wysokiej i niskiej akrecji. Zwykle warunki takie jak na rycinie 5 występują tylko w ograniczonych obszarach dysku, na przykład w obszarze częściowej jonizacji wodoru. Jeśli jednak ten region zawiera wystarczającą masę, cykl graniczny wpłynie na cały dysk. Uważa się, że jest to przyczyną wybuchów nowych karłowatych w zmiennych kataklizmicznych.

Procesy przenoszenia momentu pędu

Historycznie pomysł, że w dyskach istnieje jakaś forma turbulencji hydrodynamicznych, odegrał znaczącą rolę. Było to już częścią koncepcji Kanta i Laplace′a, którzy sugerowali, że Układ Słoneczny powstał z początkowo gazowej chmury przypominającej dysk. Jeśli ?m jest mikroskopową lepkością gazu, liczba Reynoldsa r2/?m w dysku akrecyjnym jest bardzo duża, co w mechanice płynów nazywa się sytuacją "gwałtownej turbulencji" (gdzie wysokie liczby Reynoldsa i turbulencje są uważane za równoważne). Zakłada się, że przepływ ścinający w dysku byłby niestabilny i przekształciłby się w turbulencję, jak w przepływach ścinających w laboratorium. Zostało to zakwestionowane w społeczności astrofizycznej ze względu na fakt, że przepływ w chłodnym dysku jest zbliżony do orbit Keplera, które są bardzo stabilne. W chwili pisania tego tekstu kwestia ta jest nadal kontrowersyjna, ale wydaje się całkiem możliwe, że przepływ gazów keplerowskich w rzeczywistości nie powoduje turbulencji hydrod∼ynamicznych. Ściśle analogicznym przypadkiem laboratoryjnym jest wirujący przepływ Couette′a. Co istotne, ten eksperyment nie wykazał turbulencji dla warunków odpowiadających dyskowi akrecyjnemu, w którym częstotliwość rotacji maleje wraz z odległością, ale właściwy moment pędu wzrasta (chociaż turbulencje obfitują w inne wartości parametrów). Próby wykazania turbulencji w tym przypadku za pomocą badań analitycznych lub symulacji numerycznych eksperymentu również zakończyły się niepowodzeniem. Wśród procesów, o których wiadomo, że działają, są spiralne fale uderzeniowe. W dużym dysku (w tym sensie, że promień zewnętrzny jest znacznie większy niż promień wewnętrzny) małe zaburzenie ściskające rozchodzące się do wewnątrz zmienia się w słabą falę uderzeniową. Rozproszenie podczas wstrząsu tłumi falę, ale ponieważ fala rozchodzi się również w przepływ o rosnącej prędkości, interakcja między falą a średnim przepływem przez wstrząs zwiększa jego amplitudę. W przypadku braku innych procesów tłumiących falę, szok o skończonej sile rozwija się dzięki równowadze między rozproszeniem wstrząsu a pobraniem energii ze średniego przepływu. Proces ten wytwarza niewielką ilość transportu momentu pędu, odpowiadającą α = 0,01(H/r)3/2. W przypadku dysków protogwiazdowych mieści się to w zakresie wartości wywnioskowanych z obserwacji, ale jest zbyt niskie dla zmiennych kataklizmicznych i rentgenowskich układów podwójnych. Jeśli dysk jest na tyle masywny, że grawitacja własna jest ważna, możliwy jest transport momentu pędu przez niestabilność grawitacyjną. Wewnętrzne tempo wzrostu niestabilności grawitacyjnej jest rzędu (2πG?)1/2. Jeśli jest większa niż szybkość ścinania ?Ω, niestabilność dysku może wzrosnąć; jeśli jest mniejszy, potencjalne perturbacje zostają rozerwane, zanim będą mogły się rozrosnąć. W odniesieniu do charakterystycznej masy dysku Md = 2π?r2ρH warunek ten można zapisać jako Md > MH/r. Takie dyski nazywane są samograwitującymi. Własna grawitacja jest ważniejsza w chłodnych dyskach o małym współczynniku proporcji H/r. Przy przyjętych lepkościach można oszacować masy dysków w obserwowanych układach. W przypadku rentgenowskich układów podwójnych i zmiennych kataklizmicznych okazują się one dość małe, mniejsze niż 10-8 M⊙ , a grawitacja własna nie ma znaczenia. Natomiast w zewnętrznych częściach dysków w AGN, a w szczególności w dyskach protogwiazdowych, istotna może być grawitacja własna. W takim przypadku rozważmy chłodzenie dysku przez promieniowanie, tak że H/r maleje z czasem. Po osiągnięciu progu niestabilności powstają nieosiowosymetryczne nieregularności o skalach długości rzędu H, które wywierają na siebie siły. Przepływ ścinający działający na te siły rozprasza energię, która z kolei ogrzewa dysk. Równowaga zostaje osiągnięta w temperaturze tuż powyżej progu niestabilności grawitacyjnej, a moment pędu jest przenoszony przez siły grawitacji i ciśnienia między zaburzeniami. Proces ten prawdopodobnie będzie ważny w przypadku młodych dysków protogwiazd, o masach rzędu kilku procent masy Słońca. Obecnie ulubiony proces dysków niegrawitujących polega na tym, że większość dysków jest częściowo lub całkowicie zjonizowana, a zatem wspiera pola magnetyczne. Możliwość, że rzeczywisty transport momentu pędu w dyskach jest wykonywany przez jakąś formę pola magnetycznego o małej skali, została już zaproponowane przez Shakura i Sunyaev wraz z wprowadzeniem przez nich założenia α-lepkości. Można wykazać, że początkowo słabe pole magnetyczne w dysku akrecyjnym jest niestabilne, a jego gęstość energii rośnie poprzez pobieranie energii z przepływu ścinającego. Matematyka tego procesu została obliczona około 1960 roku przez Velikhova i Chandrasekhara, jego fizyczną interpretację podali Fricke w 1972 roku, a jego znaczenie dla dysków akrecyjnych ostatecznie zrealizowali Balbus i Hawley w 1992 roku. Liczne trójwymiarowe symulacje numeryczne od tego czasu pokazały, jak ta niestabilność daje powstanie postulowanej wcześniej turbulencji magnetycznej. Dla wystarczająco zjonizowanych dysków proces daje efektywną lepkość α ˜ 0,1. Jest to pole magnetyczne o małej skali, ze skalą długości w kierunku promieniowym rzędu grubości dysku H i wydaje się zachowywać z grubsza zgodnie z oczekiwaniami procesu lepkiego. Wydaje się, że pole magnetyczne przełamuje ograniczenia dynamiczne, które zapobiegają turbulencji przepływu keplerowskiego za pomocą środków czysto hydrodynamicznych. Pod pewnymi względami proces ten przypomina zaproponowaną wcześniej turbulencję hydrodynamiczną, ale różni się też w ważnych aspektach. Na przykład transport momentu pędu jest zdominowany przez naprężenia magnetyczne (Maxwella), a nie przez ruchy płynu.

Planety wewnątrz dysków

Planety wyrastają z dysku protogwiazdy w tym samym czasie, w którym powstaje gwiazda . Planeta taka jak Jowisz jest wystarczająco masywna, aby znacząco wpłynąć na dynamikę tego dysku. Dzięki efektowi pływowemu usuwa szczelinę, obszar o niskiej gęstości gazu wokół swojej orbity, jak pokazano na rycinie 6. Siła pływowa wzbudza fale w dysku, które rozchodzą się z dala od planety. Poprzez siły pływowe, planeta przyciąga gaz z boków szczeliny, który gromadzi się na niej w postaci dwóch strumieni. Z drugiej strony dysk wywiera również na planetę moment grawitacyjny. Pod wpływem tej siły zmienia się moment pędu planety. Porusza się na inną orbitę, zwykle bliżej gwiazdy. Planety w naszym Układzie Słonecznym prawdopodobnie nie znajdują się zatem w odległościach, w których rozpoczęło się ich formowanie. Ekstremalnym przykładem tego procesu "dryfujących planet" mogą być masywne planety obserwowane na bardzo ciasnych orbitach wokół niektórych pobliskich gwiazd

Procesy radiacyjne, akrecja dwutemperaturowa

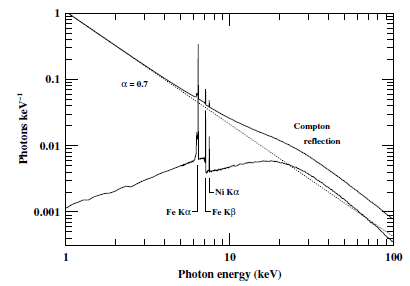

Promieniowanie wytwarzane przez dysk zależy od jego grubości optycznej τ . Energia uwolniona w dysku w wyniku rozpraszania lepkości, na jednostkę powierzchni i czasu, w odległości r od centralnej masy M jest rzędu W = GMM˙/r3. Ciepło to rozprasza się przez promieniowanie. Jeśli τ (dokładniej grubość optyczna dla procesów absorpcji) jest duże, promieniowanie emitowane na powierzchnię jest w przybliżeniu widmem ciała doskonale czarnego. Przybliżona temperatura powierzchni Ts chłodnego optycznie grubego dysku jest następnie określona równaniem (2), gdzie R zastąpiono odległością r. Jeśli akrecja jest stała, tak że ˙M jest niezależne od r, przewidywana temperatura zmienia się jako r-3/4. W przypadku dysków protogwiazdowych i dysków w zmiennych kataklizmicznych temperatury te są zbliżone do normalnych powierzchni gwiazd, a te same procesy promieniowania decydują o szczegółach emitowanego widma. Podczas akrecji czarnych dziur i gwiazd neutronowych przewidywane temperatury s∼∼ą rzędu 1 keV (107 K). Rzeczywiście, widma rentgenowskie tych obiektów często pokazują składową, która zgadza się z tą prognozą. Zwykle jednak występuje dodatkowy twardy składnik znacznie bardziej energetycznych fotonów, około 100 keV. Często dominuje w promieniowanej energii. W tych układach podwójnych znajduje się dodatkowy składnik plazmy akrecyjnej, który zachowuje się inaczej niż optycznie gruby dysk. Dokładna natura tej plazmy jest jednym z klasycznych problemów astronomii rentgenowskiej, który w chwili pisania tego tekstu nie został całkowicie rozwiązany. Z obserwowanego widma wydaje się, że jest to plazma termiczna o niewielkiej grubości optycznej (τ ˜) i temperaturze około 100 keV, znacznie wyższej niż chłodny dysk. Głównym procesem wytwarzania twardych fotonów w takich warunkach jest odwrotne rozpraszanie Comptona miękkich fotonów przez gorące elektrony. W sąsiedztwie czarnych dziur i gwiazd neutronowych akrecja jest możliwa nie tylko przez chłodny optycznie gruby dysk. Teoria przewiduje również możliwość akrecji poprzez stan gorący (por. omówienie powyżej w części "Cienkie dyski"). W tym stanie protony mają temperaturę zbliżoną do temperatury wirialnej, podczas gdy elektrony są znacznie chłodniejsze. Przepływ akrecyjny jest geometrycznie gruby (H/r ˜ 1), ale optycznie cienki. W tych warunkach oddziaływania kulombowskie między jonami i elektronami mogą być powolne w porównaniu z czasem akrecji (w zależności od szybkości akrecji i parametru lepkości). Ponieważ elektrony promieniują znacznie wydajniej i są nieefektywnie ogrzewane przez jony, pozostają znacznie chłodniejsze niż jony: plazma akrecyjna nie jest w równowadze termicznej. Szybkość interakcji Coulomba maleje wraz ze wzrostem temperatury elektronu, podczas gdy straty promieniowania przez odwrotny Compton i promieniowanie synchrotronowe rosną. W przepływie o niewielkiej głębokości optycznej odwrotne straty Comptona rosną wykładniczo powyżej około 100 keV, więc jest to nieco naturalna temperatura aby spodziewać się emitowanego promieniowania. Możliwość takiego dwutemperaturowego przepływu akrecyjnego w celu wyjaśnienia twardych widm rentgenowskich układów podwójnych została już zaproponowana na początku ery astronomii rentgenowskiej. Geometria takiego przepływu i charakter jego interakcji z komponentem chłodnego dysku są jednak nadal niepewne.

Dżety z dysków

Wydaje się, że większość systemów z dyskami akrecyjnymi jest zdolna do wytwarzania silnie skolimowanych wypływów zwanych dżetami, przynajmniej w niektórych okresach swojego istnienia . Dżety z relatywistyczną prędkością przepływu są znane z akrecyjnych czarnych dziur, zarówno dziur o masie gwiazdowej w rentgenowskich układach podwójnych, jak i masywnych dziur w AGN. Dżety o mniejszych prędkościach są wytwarzane przez protogwiazdy. Są również znane z co najmniej jednej akrecyjnej gwiazdy neutronowej (Cir X-1) i akrecyjnego białego karła (R Aqr). Związek między dyskami i dżetami jest zatem sugestywny, ale jednocześnie zagadkowy. Chociaż dżety zawsze wydają się być kojarzone z systemami akrecyjnymi, w których istnieją bezpośrednie lub pośrednie dowody na istnienie dysku, nie wszystkie systemy z dyskami wytwarzają dżety lub nie zawsze. Dobrym przykładem są OBIEKTY HERBIG-HARO wytwarzane przez dżety z protogwiazd, które wyraźnie pokazują, że dżety w tym przypadku są epizodyczne lub wysoce zmienne w czasie.

Podsumowanie typów dysków

W skali gwiezdnej dyski są wytwarzane w układach podwójnych przez przelewanie się gazu z jednego ze składników na drugi. Rozmiary tych dysków są tak duże, jak normalne gwiazdy, od kilku dziesiątych do kilku promieni słonecznych. Jeśli gwiazda pierwotna (gwiazda odbierająca masę) jest białym karłem, tak jak w zmiennych kataklizmicznych, wewnętrzne części dysku promieniują głównie w zakresie UV, a zewnętrzne w świetle widzialnym. Przenoszenie masy przez te dyski jest często niestabilne, powodując wybuchy nowych karłowatych. Jeśli pierwotną jest gwiazda neutronowa lub czarna dziura o masie gwiazdowej, wewnętrzny dysk promieniuje w promieniach rentgenowskich. Transfer masy w tych dyskach jest również niestabilny przy niskich szybkościach transferu, powodując tak zwane miękkie transjenty rentgenowskie. Czasami wytwarzają dżety z relatywistycznymi prędkościami. Dyski wokół gwiazd w procesie formowania, dyski protogwiazdowe, są znacznie większe (około 100 jednostek astronomicznych). Ich wewnętrzne regiony promieniują w zakresie widzialnym, a zewnętrzne w zakresie fal radiowych i podczerwonych. Prawdopodobnie są również niestabilne, powodując wybuchy FU Ori i są związane z dżetami i obiektami Herbiga-Haro. Dyski w AGN obracają się wokół masywnych ((106-109)M ) czarnych dziur w centrach aktywnych galaktyk. Ich centralne obszary promieniują zarówno w zakresie UV, jak i rentgenowskim i często wytwarzają relatywistyczne dżety obserwowane w dwupłatowych źródłach radiowych. Ich rozmiary są nieco niepewne, ale prawdopodobnie rzędu parseka lub większe. Dyski są również widoczne wokół BE STARS. Uważa się, że masa w tych dyskach jest powoli wyrzucana przez szybko obracającą się gwiazdę. Niektóre z ich właściwości są podobne do dysków akrecyjnych, ale z masą raczej odpływającą niż akrecyjną na gwiazdę. Czasami nazywane są dyskami wydalającymi lub wydalającymi.

Aktywne jądra galaktyczne: zmienność

Badania zmienności miały zasadnicze znaczenie dla zrozumienia fizyki AKTYWNYCH JĄDR GALAKTYCZNYCH, AGN, ponieważ rozmiar obszaru emitującego ogromną ilość energii charakterystycznej dla AGN jest zbyt mały, aby można go było rozdzielić nawet za pomocą istniejących lub planowanych INTERFEROMETRÓW optycznych/podczerwonych (IR). AGN emitują promieniowanie kontinuum pochodzące z okolic CZARNA DZIURA. Emitują również intensywne i szerokie linie emisyjne pochodzące z szybko poruszających się chmur gazu znajdujących się w małym obszarze wokół źródła kontinuum: regionie szerokich linii lub BLR. Poziom strumienia kontinuum i intensywność widmowych linii emisyjnych emitowanych przez AGN podlegają zmianom w skali czasowej od godzin do lat, w zależności od zakresu energii i wewnętrznej jasności AGN. Kiedy strumień emitowany przez źródło energii zmienia się znacząco (powiedzmy o współczynnik 2) w skali czasu t, ta zmiana strumienia wyznacza granicę rozmiaru R obszaru emitującego, tak że R ≤ ct. W AGN połączenie ogromnej ilości emitowanej energii i bardzo małych rozmiarów obszarów emisji określonych przez krótką skalę czasową zmienności nie jest zgodne z energią wytwarzaną w normalnych procesach gwiezdnych. Najpopularniejszym modelem produkcji energii w AGN i podstawą obecnego paradygmatu jest to, że AGN/kwazary są zasilane przez akrecję materii na SUPERMASYWNĄ CZARNA DZIURĘ. Przy wyższych energiach fotonów obserwuje się szybszą i większą zmienność amplitudy, m.in. zdjęcia rentgenowskie są różne niż optyczne. Skale czasowe zmienności są zwykle dłuższe w obiektach z natury rzeczy jaśniejszych. Skale czasowe oraz korelacje i opóźnienia między zmianami strumienia kontinuum i różnymi intensywnościami linii widmowych dostarczają informacji o naturze procesów fizycznych emitujących linie i kontinuum oraz o lokalizacji regionów, z których one pochodzą. Termin AGN jest tutaj używany niezależnie od przesunięcia ku czerwieni i jasności, a zatem obejmuje terminy Seyfert 1 i QSO lub kwazar, które są często używane do oddzielnego oznaczania AGN o średniej i wysokiej jasności. Ogólnie rzecz biorąc, dla 1 Seyferta dostępnych jest więcej danych o wyższej jakości niż dla kwazarów. Powodem jest to, że jest ich wiele, a całkiem sporo znajduje się w odległości 100 Mpc od Ziemi i można je łatwo zaobserwować za pomocą obecnego instrumentarium. Natomiast kwazary są rzadkie, a nawet te najbliższe znajdują się w tak dużych odległościach od nas, że strumień odbierany na Ziemi jest znacznie mniejszy niż z 1s Seyferta (jest jeden wyjątek, 3C 273). Podsumowując, zasób wiedzy o zmienności AGN jest zdominowany przez obserwacje Seyferta 1s, które doprowadziły do modeli fizycznych, które w zadowalający sposób wyjaśniają obserwowane zjawiska. Pozostaje zbadać, w jaki sposób modele te odnoszą się do znacznie jaśniejszego i znacznie słabszego AGN. AGN, które są przedmiotem tego artykułu, to te, w których centralne źródło promieniowania optycznego, UV i rentgenowskiego jest obserwowane bezpośrednio i gdzie zmiany nie są wzmacniane przez efekty relatywistyczne . W przypadku prawie tuzina Seyferta 1, a zwłaszcza trzech z nich (NGC 4151, NGC 5548 i NGC 7469) oraz kwazara 3C 273, duża międzynarodowa współpraca zorganizowała długie, spójne kampanie obserwacyjne, niektóre obejmujące jednoczesne obserwacje w zakresie optycznym, Zakresy promieniowania UV i rentgenowskiego, generujące duże ilości danych o jednolitej jakości i gromadzonych z optymalnym czasem próbkowania. Szereg 1 Seyferta (∿30) było monitorowanych mniej intensywnie, ale wciąż wystarczająco, aby ustalić, że wyniki z najlepiej zbadanych 1 Seyferta są reprezentatywne.

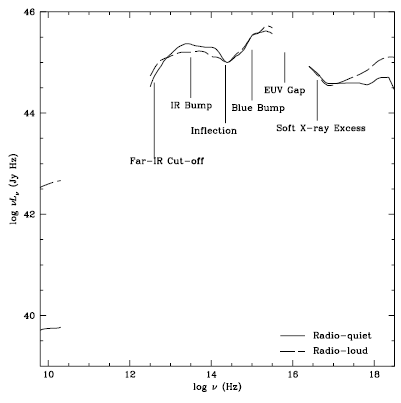

Zmienność strumienia kontinuum

Widmo elektromagnetyczne (widmo kontinuum) radio-cichego AGN, po odjęciu kontinuum gwiazd emitowanego przez galaktykę macierzystą, rozciąga się od ∿1 mm do ∿100 keV z wyraźnym szerokim pikiem w zakresie ekstremalnego UV (EUV) i drugorzędny pik w IR . Emisja promieniowania rentgenowskiego jest zdominowana przez składową prawa mocy (1-10 keV; α ≃ 0,9 gdzie f? ∝ ? ? α), która narasta w zakresie twardego promieniowania rentgenowskiego (> 50 keV), prawdopodobnie z odcięciem około 100 keV. Przypomnijmy tutaj, że w teorii dysków akrecyjnych, narosła materia wiruje w kierunku centrum pod wpływem przyciągania grawitacyjnego czarnej dziury. Sprawa jednak nie toczy się swobodnie. Ma wewnętrzne naprężenie (najprawdopodobniej pochodzenia magnetycznego), którego rozpraszanie wytwarza ciepło, a także wyznacza skalę czasową propagacji narosłej materii w kierunku centrum. Astronomowie mówią o ogrzewaniu dysku przez lepkość i o lepkich skalach czasowych, a teoretycy mogą obliczyć energię wytwarzaną przez lepkość, wynikające z tego widmo emitowane przez dysk oraz skale czasowe, w których zmienia się promieniowanie z dysku w odpowiedzi na zmieniającą się szybkość akrecji (DYSK AKRECJI). Obserwowany kształt widmowy kontinuum AGN w zakresie 1200-5000 Å (lub 10-2,5 eV) jest z grubsza zgodny z emisją termiczną z dysku akrecyjnego. Jednak wahania strumienia kontinuum UV występują w skalach czasowych dni, tygodni lub miesięcy, które są o wiele rzędów wielkości krótsze niż skale czasowe oczekiwane na podstawie zmian tempa narastania. Co ciekawe, w NGC 4151 i NGC 5548 strumień promieniowania rentgenowskiego o średniej energii (2-10 keV) oraz strumień optyczny/UV zmieniają się jednocześnie , przy czym wahania wysokoenergetyczne są znacznie większe niż wahania niskoenergetyczne. Podsumowując, obserwacje te sugerują model, w którym powierzchnia dysku jest naświetlana przez centralne zmienne źródło promieniowania rentgenowskiego. Uważa się, że sama zmienność źródła promieniowania rentgenowskiego jest spowodowana wybuchowymi ponownymi połączeniami linii pola magnetycznego przenikających dysk akrecyjny i koronę (gaz gorących elektronów otaczający centralne części dysku) poprzez zjawisko przypominające rozbłyski słoneczne w korona słoneczna. Znaczna część energii akrecji jest zużywana w ten sposób na ogrzewanie korony. Gorące elektrony przenoszą część swojej energii na otaczające fotony UV (emitowane przez dysk) i miękkie fotony rentgenowskie oraz wytwarzają fotony rentgenowskie o średniej i twardej energii poprzez odwrotną emisję Comptona. Ten "model komtonizacji i ponownego przetwarzania" wyjaśnia prostą korelację między promieniowaniem rentgenowskim a emisją UV w krótkich skalach czasowych w NGC 4151 i NGC 5548, a także wyjaśnia średnie nachylenie widma rentgenowskiego, granica wysokoenergetyczna i inne cechy widm rentgenowskich AGN. Ale życie nie jest takie proste, a dobra korelacja między promieniowaniem rentgenowskim a strumieniem UV obserwowana w NGC 4151 i NGC 5548 mogła być szczęśliwym zbiegiem okoliczności w skomplikowanej interakcji między gorącym gazem elektronowym, fotonami UV i fotonami rentgenowskimi ("który jest kurczakiem, a który jajkiem?"). W rzeczywistości, w trzecim jądrze Seyferta 1 intensywnie obserwowanym jednocześnie w promieniach UV i rentgenowskim, NGC 7469, zmiany UV czasami pozostają w tyle za zmianami rentgenowskimi, a czasami są jednoczesne ze zmianami rentgenowskimi. Ten przypadek stawia poważne wątpliwości co do przedstawionego wcześniej obrazu ponownego przetwarzania. Bliższe przyjrzenie się danym ujawnia jednak uderzające podobieństwo zmian w dwóch zakresach energii, co sugeruje podstawowy związek między emisją w dwóch zakresach energii, np. jak ogólnie zapewnia Comptonization. Najbardziej ekstremalna zmienność miękkiego promieniowania rentgenowskiego występuje w wąskich galaktykach Seyferta 1 (NLS1), podzbiorze AGN z bardzo intensywną emisją miękkiego promieniowania rentgenowskiego i bardzo stromymi widmami miękkiego promieniowania rentgenowskiego, wąskimi optycznymi liniami emisyjnymi i wyraźną optyczną emisją Fe II . Aby wyjaśnić brak szerokich linii w NLS1, zaproponowano, że intensywne miękkie promieniowanie rentgenowskie może zdmuchnąć wewnętrzny obszar szerokich linii (BLR) lub zjonizować go do stanów obecnie niewykrywalnych. Strome widmo miękkiego promieniowania rentgenowskiego NLS1 może wskazywać na dużą szybkość akrecji lub małą masę czarnej dziury. Przechodząc teraz do zakresu podczerwieni, zmiany, jeśli w ogóle zostaną wykryte, mają mniejszą amplitudę i dłuższą skalę czasową niż w zakresie optycznym i są zgodne z opóźnioną reakcją pyłu wokół centralnego źródła na długoterminowe zmiany promieniowania UV i strumień kontinuum rentgenowskiego.

Zmiany linii emisji

Metoda szacowania masy czarnej dziury

Monitorowanie zmian strumienia kontinuum i intensywności linii widmowych kilku jedynk Seyferta wykazało, że intensywności linii widmowych naśladują zmiany kontinuum optycznego/UV, ale z pewnym opóźnieniem czasowym τ. Opóźnienie to jest interpretowane jako czas potrzebny, aby światło ze źródła centralnego kontinuum znajdującego się w bezpośrednim sąsiedztwie czarnej dziury dotarło do obłoków gazowych emitujących linie widmowe (i znajdujących się wokół źródła centralnego kontinuum) i zwiększyło lub zmniejszyło emisyjność gaz . Opóźnienie czasowe τ jest miarą odległości d ∿ cτ chmur gazu emitującego linie od centralnego źródła kontinuum. Metodę tę można rozszerzyć, aby mapować obszar emisji liniowej i jest ona znana jako "mapowanie pogłosu". Zgrubne oszacowanie masy centralnej czarnej dziury można następnie obliczyć na podstawie zmian zmiennej składowej linii emisyjnej, łącząc szerokość składowej (która daje prędkość wirialną obłoków gazu) i τ (co jest opóźnieniem o w którym zmiany

składników następują po zmianach kontinuum). Założenie, że ruchy chmur są ruchami orbitalnymi w polu grawitacyjnym czarnej dziury, jest mocno poparte faktem, że niebieskie i czerwone skrzydło dowolnej linii lub składowej linii zmieniają się razem (tzn. jedno skrzydło nie zmienia się przed ani po drugim jeden, na pierwsze zamówienie; patrz poniżej). Ta metoda wyznaczania masy centralnej czarnej dziury została zastosowana do kilkunastu AGN i daje wartości w przedziale od kilku 106M⊙ do kilku 108M⊙ . Pole prędkości gazu Jednym z kluczowych elementów wniesionych przez badania lotności jest to, że najszersze linie emisyjne zmieniają się z największą amplitudą iw najkrótszej skali czasowej, co wskazuje, że najszybciej poruszający się gaz znajduje się najbliżej środka. Szczegółowe zmiany intensywności i profilu linii dostarczają odpowiedzi na kluczowe dla określenia masy pytanie, czy obłoki są związane grawitacyjnie z centralną czarną dziurą: Zmiany profilu

linii nie pokazują systematycznego wpływu jednej skrzydło reaguje przed drugim, czego można by się spodziewać w przypadku przepływów promieniowych: zaobserwowano, że niebieskie skrzydło zmienia się jako pierwsze w przypadku przepływów na zewnątrz i wiatrów kulistych, a skrzydło czerwone byłoby obserwowane jako pierwsze w przypadku akrecji sferycznej. To oraz fakt, że najszybciej poruszający się gaz znajduje się najbliżej środka, mocno sugeruje, że chmury o wysokiej jonizacji znajdują się w ruchu orbitalnym (ruchy chaotyczne lub rotacyjne) w polu grawitacyjnym czarnej dziury, z jedynie niewielkimi składnikami opadania netto lub odpływ. Ruchy chaotyczne są wykluczone, ponieważ chmury gazu zostałyby zniszczone podczas przechodzenia przez dysk akrecyjny. Najbardziej szczegółowe wyniki dotyczące pola prędkości w BLR pochodzą z intensywnego monitorowania profilu linii C IV podczas miesiąca życia NGC 4151′, z prawie całkowitym próbkowaniem 1 d w odstępie 35 dni. Analiza zmian w każdym przedziale prędkości w profilu linii C IV pokazuje, że zmiany są zgodne z ruchami grawitacyjnymi wokół masy około 107 M . Wartość ta zgadza się z wartością wynikającą z obserwacji całego widma UV NGC 4151 w innych epokach, które wykazują liniową zależność między czasem odpowiedzi linii a odwrotnością kwadratu szerokości linii. Podobne badanie NGC5548 daje masę (5 ± 3) × 107 M⊙ . Należy zauważyć, że zarówno w NGC 5548, jak i NGC 4151 istnieje prawdopodobnie słaba sygnatura składnika opadającego. Inne AGN dają spójne wyniki (choć mniej szczegółowe) i wstępnie stwierdza się, że szerokość linii jest zdominowana przez rotację. Stanowi to podstawę oszacowania masy czarnej dziury na podstawie odpowiedzi intensywności linii emisyjnych na zmiany strumienia kontinuum. Niepewność związana z tą metodą jest trudna do oszacowania i prawdopodobnie jest mniejsza niż współczynnik 10.

Model "dysku i wiatru".

W widmach AGN występują linie niskojonizacyjne, takie jak linie Balmera i linie Fe II i Mg II oraz linie highionizacji (najsilniejsze są linie C IV, N V, He II, Si IV). Z interpretacji obserwacji wynika, że linie o niskiej jonizacji pochodzą od płaskiego skupiska bardzo gęstych chmur (Ne ≥ 1011 cm-3 i całkowitej grubości optycznej 1024 cm-2), które utożsamiane są z częścią stosunkowo chłodną (temperatura powierzchni 5000 K) dysku akrecyjnego. Natomiast linie o wysokiej jonizacji pochodzą ze stosunkowo bardziej rozcieńczonego ośrodka, powyżej i poniżej dysku, przy czym linie najbardziej zjonizowanych pierwiastków są najszersze. Wskazuje to, że stopień jonizacji jest skorelowany z prędkością gazu. Co ciekawe, linie o wysokiej jonizacji nie znajdują się dokładnie na przesunięciu ku czerwieni linii o niskiej jonizacji (emitowanych przez dysk akrecyjny), które same znajdują się na przesunięciu ku czerwieni galaktyki macierzystej. Są przesunięte w kierunku błękitu (od 0 do ∿ 1500 km s-1) w stosunku do dysku i galaktyki macierzystej, co wskazuje, że silnie zjonizowany gaz płynie w naszą stronę. (Dzięki symetrii przepływ prawdopodobnie oddala się od nas, po drugiej stronie dysku, ale jest niewidoczny, ponieważ dysk jest nieprzezroczysty). Połączenie rotacji i wypływu z dysku sugeruje i jest zgodne z modelem, w którym linie o wysokiej jonizacji są emitowane przez chmury gazu wyłaniające się z dysku, wciąż zachowując dużą część momentu pędu, który gaz miał w dysku. Takie ruchy są przewidywane przez magnetohydrodynamiczny model dysków akrecyjnych, w których wiatry przyspieszone magnetycznie powstają z włókien wyciągniętych z pierwotnie gęstego, nisko zjonizowanego materiału dysku akrecyjnego i poddanych intensywnemu centralnemu polu jonizującemu. Tworzy to silnie zjonizowany wiatr nad i pod dyskiem. Fizyka tych zjawisk jest jednak skomplikowana i wiele cech tego obiecującego modelu pozostaje obecnie nieokreślonych.

Bieżące problemy i przyszły rozwój